#6 Classificare l'inclassificabile

Ripassare la storia per salvare il futuro: i sistemi di classificazione come terreno di lotta politica e sociale, dall'apartheid alle democrazie europee.

Ciao! Se stai leggendo questo numero di Resistere all’inevitabile, voglio che tu sappia che ti sono molto grata. Ho sempre scritto che il motivo che mi ha portata ad aprire questa newsletter non era quello di accumulare pubblico e lettrici/ori, ma di condividere con chiunque lo volesse le domande e riflessioni che mi pongo, per sistematizzare i pensieri e renderli più forti insieme. Non è per nulla scontato siate in così tantə (1300k per l’ultimo numero!) a continuare ad aprire una newsletter che non rispetta ritmi, arriva una volta ogni tanto, senza annunciarsi e senza pianificazioni.

Dedico questo episodio alla mia nuova avventura di ricerca, quella in cui sarò coinvolta per i prossimi due anni, di cui potete leggere alla fine di questa newsletter. Nelle prossime righe, dedicate ai sistemi di classificazione, condivido qualche pensiero di questi giorni, legato ai temi su cui lavorerò.

⚠️ Ma prima, un TW: per poter riportare i fatti e sottolineare il loro inaccettabile legame con l’attualità, ho voluto riportare dettagliatamente la categorizzazione razziale avvenuta con l’apartheid, per cui se pensi di non volerla attraversare, puoi fermarti qui.

Per tutte le altre persone, spero possa essere utile per riflettere sul nostro presente.

Andiamo!

Come scienziati dell'informazione, i problemi teorici e pratici della categorizzazione, della denominazione e del significato dei gruppi razziali ed etnici possono essere visti come dati empirici sui problemi associati all'organizzazione della conoscenza, alla rappresentazione, alla classificazione e alla definizione di standard.

Alice Robbin (1998), in Geoffrey C. Bowker & Susan Leigh Star (2000)

Nel 2000, Alice Robbin pubblicò uno studio sugli “Standard per il mantenimento, la raccolta e la presentazione dei dati federali sulla razza e l’etnia” - noti anche come “Statistical Policy Directive 15” - il sistema di classificazione che dal 1977 costituiva la base della raccolta e della presentazione dei dati sulla razza e l’etnia da parte del governo degli Stati Uniti. Dall’analisi di Robbin emergeva quanto sia fondamentale, per chi si occupa di scienza dell’informazione, soprattutto governativa, tenere conto del fatto che i sistemi di classificazione non sono strumenti neutrali che riflettono e misurano oggettivamente il mondo empirico. Essi non possono essere isolati dal contesto politico più ampio: sono “strettamente legati alle politiche pubbliche e, nel caso della classificazione dei gruppi razziali ed etnici, costituiscono una politica sociale altamente contestata su cui c’è poco consenso pubblico”.

Se cambia la politica pubblica di riferimento, cambiano di conseguenza i sistemi di classificazione.

Nel loro fondamentale libro del 2000 Sorting Things Out: Classification and Its Consequences, l’informatico Geoffrey C. Bowker e la sociologa Susan Leigh Star si sono interrogati su questi temi da molte prospettive diverse. Chi ha letto Tecnologia della rivoluzione (Tdr) forse ricorda alcuni riferimenti a questo libro, in particolare nel capitolo dove provo a ripercorrere una parte della costruzione sociale dell’intelligenza artificiale, che mi ha portata alla statistica. Ciò che in particolare mi interessava - e continua a interessarmi - erano le radici politiche e ideologiche molto specifiche di questa disciplina, nata dall’eugenetica, della quale i padri fondatori della statistica erano appunto i principali sostenitori.

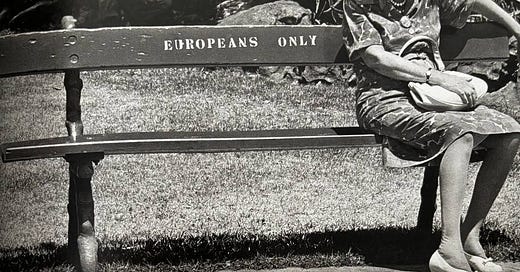

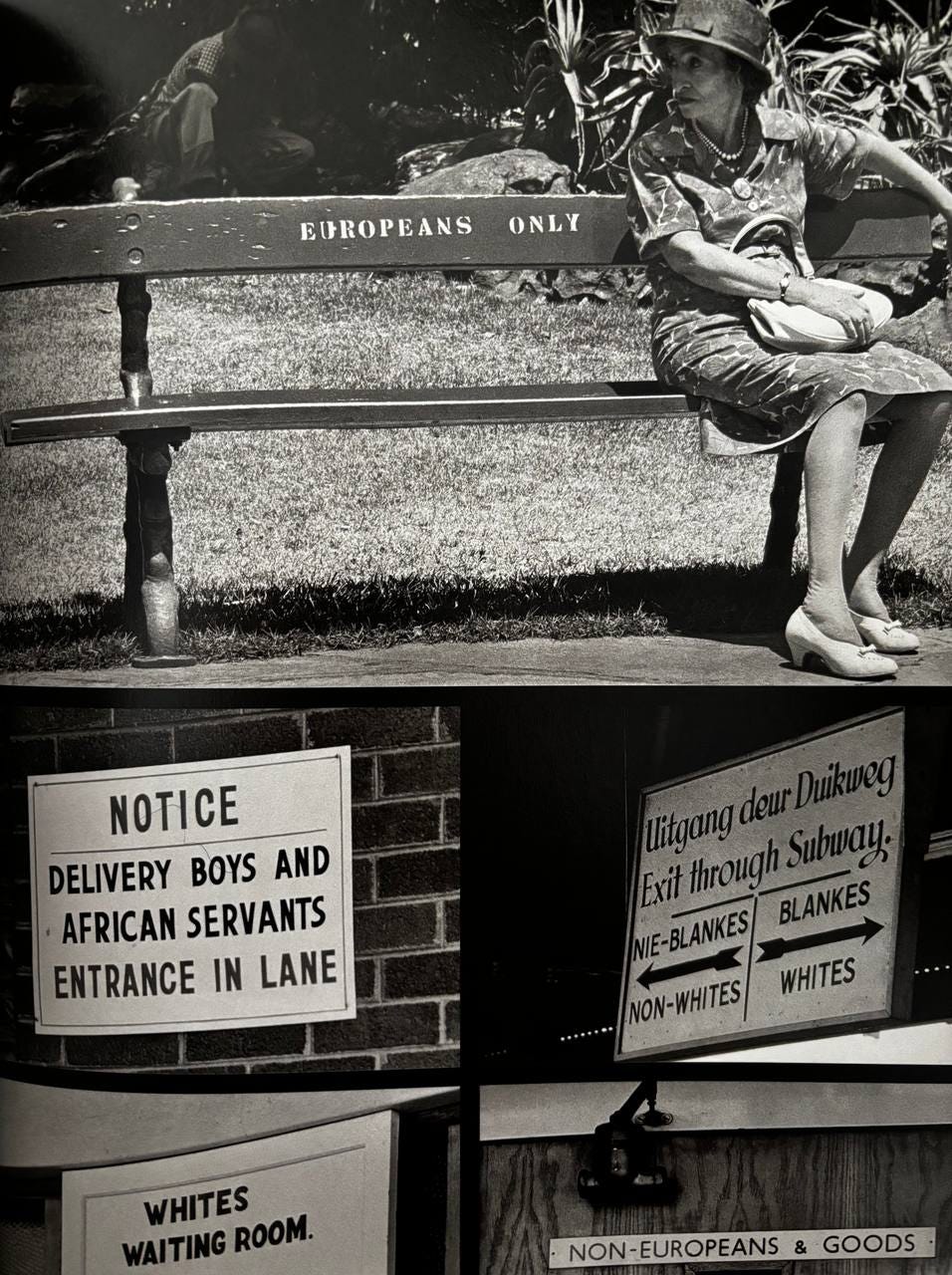

Nel loro libro, Bowker e Star discutono vari esempi empirici di classificazione, ma tra i più importanti c’è sicuramente quello instaurato durante il regime dell’apartheid in Sudafrica da parte dei coloni olandesi. Si tratta di una storia violenta e brutale all’inverosimile, che va però - io credo - ripercorsa e raccontata, soprattutto come inseparabile dalla sua infrastruttura di classificazione.

La segregazione razziale esisteva già in alcune colonie dell’attuale Sudafrica nei secoli precedenti come risultato delle prime colonizzazioni olandesi e inglesi, che cominciarono nel 1652 e durarono così per tre secoli. Ma quando nel 1948 il National Party dei boeri vinse le elezioni e instaurò la segregazione razziale, tutta la popolazione originaria che si trovava nei territori ora controllati dai bianchi perse progressivamente i propri diritti civili. L’apartheid si basava sulla non tolleranza dell’equità tra gruppi etnici, ideologia politica ispirata al nazismo e alle teorie eugenetiche di separazione e classificazione genetica proposte da statistici e matematici come Karl Pearson e Francis Galton.

L’intero funzionamento delle politiche di segregazione che durarono fino al 1991 dipendeva da un’infrastruttura di classificazione: ogni persona doveva essere categorizzata, e la loro intera esistenza (la loro casa, i diritti politici, di voto, la libertà di movimento, la proprietà, l’educazione, la tassazione, il welfare, l’uso dei mezzi pubblici…) dipendeva da questo risultato.

Resistere alla classificazione

Il tentativo di creare un sistema di book-keeping normalizzato e sistematico era inserito in un più ampio programma di distruzione umana.

Geoffrey C. Bowker & Susan Leigh Star (2000, 196)

Ogni persona veniva classificata in uno di questi quattro gruppi: europeo, asiatico, “di colore” o razza mista, Bantu (o nativo, a sua volta divisa in altre otto sotto-categorie). La categoria di persona “africana” non esisteva, perché i nazionalisti olandesi volevano essere riconosciuti come tali e tenere questa categoria per loro.

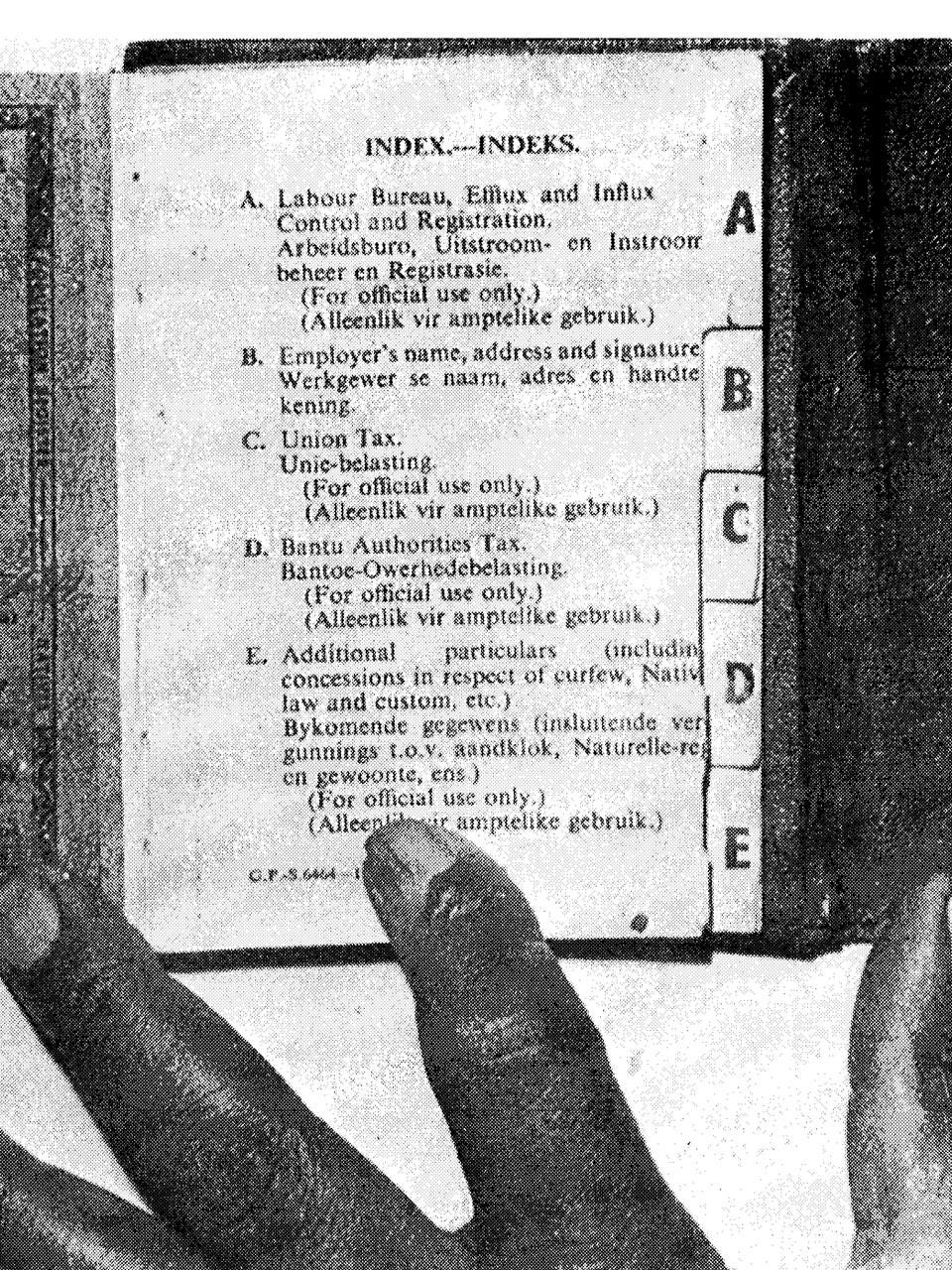

Ogni persona non-europea dai 16 anni in su doveva possedere un “reference book” di circa 95 pagine: dal giorno della loro nascita dovevano tracciare qualsiasi cosa, ogni lavoro effettuato, ogni tassa pagata, ogni visita medica. Un sistema interoperabile, che sommava qualsiasi comportamento e abitudine umana, una profilazione altamente intrusiva che però toccava solo chi era segretato.

Per funzionare a questo livello, l’apartheid doveva categorizzare “inequivocabilmente” chiunque in base alla razza, scrivono Bowker e Star. Ma di “certo” e “inequivocabile” nella classificazione non c’era nulla. Molte persone non corrispondevano alla categoria loro assegnata in base alla legge arbitraria dell’epoca. Erano in principio inclassificabili, ma il regime le forzava comunque dentro una rigida tipologia, facendo dipendere le vite di milioni di persone da questo e provocando conseguenze devastanti. Durante il regime, circa 100 mila persone presentarono domanda di riclassificazione, ma solo 1 su 10 venne accettata. Ovviamente era praticamente impossibile essere riclassificati da “di colore/misto” a “bianco”, più probabile invece che gli uffici accettassero gli errori da “Bantu” a “di colore”.

Le responsabilità analitiche di tutto questo andrebbero rintracciate ben prima della statistica e dell’eugenetica, anzitutto nella filosofia e poi nella linguistica cognitiva, che con la categorizzazione aristotelica e poi con quella prototipica hanno fissato degli standard quali-quantitativi (grazie ai quali nominiamo e comprendiamo il mondo). L’accettabilità - come oggi dovremmo sapere - così come tanti altri valori sono in tutto dipendenti dal contesto storico, politico, culturale che li codifica.

Ciò che Bowker e Star fanno emergere da questo capitolo di Sorting Things Out è la totale arbitrarietà e non-scientificità delle classificazioni voluta dalle politiche e dalle leggi, che puntavano a evidenziare la diversità e la differenza anziché la somiglianza e la convergenza. In realtà, solo gli ibridi esistevano: come scriveva Donna Haraway nel 1997 in Feminism and Technoscience, è la razza in sé a eludere qualsiasi categoria. La purezza tipizzata e l’ansia razziale si scatenavano nella sobria prosa della bioscienza categoriale, e le tassonomie che intrappolavano migliaia di persone non potevano che essere un’approssimazione. Come scriveva l’attivista e politica Helen Suzman nel 1960, si stava cercando di definire l’indefinibile.

Tempo fa, a trent’anni di distanza dall’apartheid, mi colpì molto leggere la storia di Glen Snyman, un insegnante sudafricano che fu accusato di frode per essersi identificato come “africano” in una domanda di lavoro. Nel suo Paese, Snyman viene ancora classificato come “di colore”, la categoria usata per le persone di razza mista da quando il Sudafrica era a maggioranza bianca. Avendo dichiarato di essere un maschio africano, “mentre in realtà i suoi documenti indicano che lei è un maschio di colore”, è accusato di un reato comune, e in particolare di aver cercato un vantaggio ai fini della selezione. Dal 2010 Snyman si batte contro l’uso delle categorie razziali, affermando di considerarsi “prima di tutto e soprattutto” un sudafricano.

Tecnologie della classificazione

Come riporto anche in Tdr, solo pochi anni fa grazie a una mostra fotografica di Ernest Cole ad Amsterdam ho scoperto l’esistenza del “pencil test”, una delle pratiche usate dagli ufficiali olandesi per classificare le persone nei gruppi razziali arbitrari. Le matite venivano infilate nei capelli e, a seconda della facilità con cui cadevano, la persona veniva classificata come “di colore” o “Bantu”.

Lungi dall'essere una pratica antica, dimenticata e abbandonata, la classificazione umana basata sui prototipi avviene ancora ogni giorno.

Nei regimi autoritari attuali diventa un potente strumento di controllo e repressione governativa, ma purtroppo viene impiegata sempre di più anche in contesti democratici, anche quelli percepiti come più rispettosi dei diritti civili. Chi ha letto il libro e gli episodi precedenti di questa newsletter avrà già capito quale contesto specifico ho in mente (e le radici storico-culturali con la storia precedente non sono affatto casuali).

A livello globale, sempre più Stati stanno usando sistemi di classificazione basati su tecnologie digitali che possono avere impatti di vasta portata sui diritti umani. In molti casi - ad esempio con lo scandalo sui sussidi nei Paesi Bassi - alcuni gruppi emarginati, persone che subiscono razzismo strutturale e sistemico e coloro che provengono da contesti socio-economici svantaggiati subiscono i danni maggiori. Nel contesto olandese, ormai dal 2018 (così come in altri Paesi europei) continuano a emergere pratiche problematiche messe in atto dal governo e da diverse agenzie pubbliche legate all’automazione di queste classificazioni, che al centro hanno sempre l’obiettivo di identificare un rischio nelle persone.

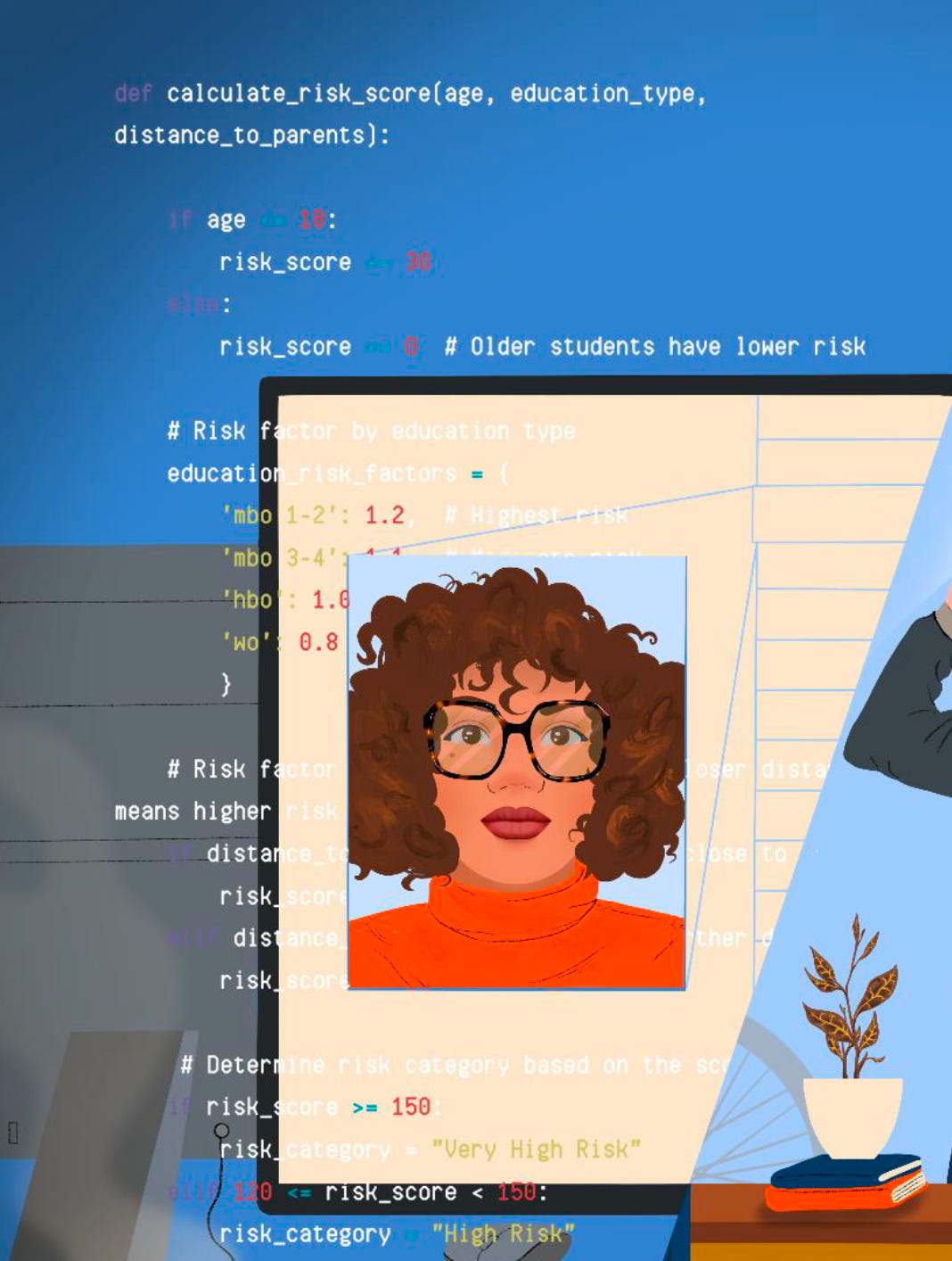

Dopo tre anni di ricerca sui processi automatizzati in uso dal governo olandese e sui loro effetti discriminatori, dopo scandali di cui si è parlato in tutto il mondo e numerose condanne, trovo sempre più assurdo che il governo continui a utilizzare progetti simili basati sulle stesse logiche. In questi giorni ho studiato un report di Amnesty International (NL) dove si racconta l’ultimo tra questi, che riguarda l’Agenzia esecutiva olandese per l’istruzione (DUO), sotto la responsabilità del Ministero dell’Istruzione.

Tutti gli studenti iscritti all’Università nei Paesi Bassi hanno diritto a una borsa di studio (o, in alternativa, a un prestito) erogata dal governo per sostenere le tasse universitarie e il costo della vita da studente. Gli studenti che vivono lontano dai genitori ricevono un importo maggiore. Dal 2012 al 2023, DUO ha utilizzato un classificatore, un sistema algoritmico di profilazione del rischio, per selezionare gli studenti da sottoporre a un’indagine su un possibile abuso di questa borsa di studio. Lo scorso anno è stato dimostrato come il software di DUO abbia discriminato sistematicamente gli studenti in base alla razza e allo status socio-economico.

A ogni studentessa o studente che veniva ingiustamente discriminatə e classificatə come a rischio di frode, veniva richiesto di restituire le somme ricevute e di pagare una multa. I criteri utilizzati da DUO - e codificati nel software - erano il livello di educazione, l’età e la distanza dalla casa dei genitori, e come riporta lo studio di Amnesty erano tutti e tre correlati con la razza, per cui le persone con un background migratorio non-europeo (come in tutti gli altri casi di discriminazione automatizzata nei Paesi Bassi) venivano classificati sempre a rischio più alto, a parità di condizioni.

In casi come questo, le implicazioni etiche riguardano questioni fondamentali di giustizia sociale ed equità.

Vi consiglio di leggere il report, se vi interessa il rapporto tra intelligenza artificiale, tecnologia e società. Soprattutto, vi consiglio di leggerlo se vi occupate di diritti umani e di giustizia sociale. Trovo sconcertante e preoccupante una certa continuità metodologica che unisce i sistemi di classificazione usati nei regimi per segregare e quelli che oggi vengono usati dalle democrazie europee. Cosa potrebbe succedere, con un cambio radicale di politiche pubbliche - come quello in atto ora in Europa - a questa infrastruttura già esistente? Sempre meno, oggi, possiamo prescindere dal guardare cosa l’automazione e i sistemi di classificazione possono fare, quando governi e aziende li usano per amplificare le discriminazioni verso alcuni gruppi sociali già esclusi, con una scala senza precedenti.

🌍 (Altre) notizie dal mondo

🇮🇹 Italia

Un gruppo di ricerca dell’Università di Torino ha presentato, in occasione del 25 novembre, un sistema di intelligenza artificiale che ha analizzato quasi 400 mila cartelle cliniche relative agli accessi al pronto soccorso Mauriziano dal 2015 al 2024 e avrebbe così rilevato un migliaio di casi di violenza di genere rimasti nascosti, invisibili al sistema sanitario nazionale.

🇺🇸 Stati Uniti

Uno strumento di valutazione, SafeRent, utilizza fattori come la storia creditizia e i debiti non legati all’affitto per assegnare un punteggio ai potenziali inquilini. Come racconta The Verge, i proprietari possono utilizzare questo punteggio per determinare se accettare o rifiutare la domanda di affitto di una persona, e il sistema ha assegnato punteggi più bassi in modo ingiusto agli inquilini neri e ispanici, così come alle persone che utilizzano sussidi, portando i proprietari a rifiutare le loro domande di alloggio. L’azienda dovrà pagherà circa 2,3 milioni di dollari ai residenti del Massachusetts nell’ambito di un accordo raggiunto con una class action.

🇪🇺 Europa

Sono usciti i risultati di un fondamentale lavoro di ricerca durato due anni e guidato da Fabio Chiusi per Algorithm Watch. Automation on the Move si occupa dei sistemi basati sull’intelligenza artificiale (IA) e dei processi decisionali automatizzati (ADM) sperimentati e utilizzati su migranti, rifugiati e viaggiatori, che troppo spesso sfuggono ai controlli democratici e raccontano di un’Europa nascosta, che dobbiamo - purtroppo - svelare e contrastare.

Particolarmente interessante dal punto di vista metodologico il racconto sulle enormi difficoltà di accesso ai dati quando si ha a che fare con istituzioni e pubbliche amministrazioni.

📂 Archivio tecnofemminista

Con molta emozione, in questi giorni sono tornata dopo sei anni nel cortile e tra i corridoi del Dipartimento di Filosofia dell’Università Statale, a Milano, non più come studentessa ma come ricercatrice.

Il cortile dove per tre anni ho pranzato tutti i giorni, facevo infinite pause sigaretta durante le giornate di studio in biblioteca, decidevo l’oggetto della tesi, ricevevo grandi delusioni sui voti - che confrontavo sempre con quelli delle amiche e compagne che mi sembravano irraggiungibili, con le quali mi chiedevo anche - ossessivamente - che cosa ci avremmo fatto noi nella vita con la filosofia. Ma poi è andata bene.

Non avrei mai potuto immaginare di tornare. Di sedermi in un ufficio a due porte di distanza da quelle dei miei professori, gli stessi che pochi anni prima tra quelle stesse mura mi facevano gli esami e influenzavano fortemente il mio futuro.

Non è cambiato niente, ma è cambiato tutto.

Dopo aver consegnato la tesi di dottorato a fine ottobre per le review esterne (sul mio profilo Instagram ho raccontato un po’ gli ultimi mesi in chiave più emotiva e personale), per i prossimi due anni lavorerò come ricercatrice Post-doc, salutando il Dipartimento di Scienze Sociali, Politiche ed Economiche per tornare a quello che mi ha formata, quello di Filosofia. Continuerò la mia ricerca sulla costruzione sociale delle tecnologie e le influenze culturali nella progettazione delle moderne tecniche di automazione, e nello specifico sarò coinvolta in un progetto sull’intelligenza artificiale e i processi di decolonizzazione, mettendo tutta l’attenzione che serve per non svuotare questa parola del suo incommensurabile significato. Mi sono ripromessa - in un mondo preso dall’hype sull’IA generativa - di continuare a occuparmi anche delle forme più classiche e meno cool di automazione, che continueranno ad avere impatti molto tangibili sulle vite delle persone.

🗓 Dove ci vediamo?

Sabato 30 alle 21 e domenica 1 alle 16 andrà in onda su Radio24, ai microfoni di "Off Topic - Fuori dai luoghi comuni", una chiacchierata su Tdr insieme ai conduttori Beppe Salmetti, Alessandro Longoni e Riccardo Poli

L’11 dicembre presenterò Tdr al Centro Nexa del Politecnico di Torino (sarò molto emozionata)

Il 17 dicembre, a Roma, presentazione bonus di Tdr al Trenta Formiche!

Per qualsiasi altro appuntamento, ci risentiamo con l’anno nuovo 📆

📬 Se siete arrivatɜ fino a qui, grazie di cuore! Per questo numero è tutto. Mi piacerebbe molto sapere cosa ne pensate, o se avete domande da condividere e/o suggerimenti. Potete sempre scrivermi a info@dilettahuyskes.eu. Se vi va di aiutarmi a creare questa piccola comunità di curiosɜ, potete condividere questa newsletter con altre persone che pensate possano essere interessate.

Ci sentiamo il prossimo mese (forse)!

Diletta