#7 La violenza di genere passa anche per l'automazione dei servizi pubblici

La storia si ripete, così come quello che imparano gli algoritmi di apprendimento automatico: questa volta in Svezia, dove l'agenzia di welfare ha discriminato donne, persone straniere e povere.

Ciao, e benvenutə all’ultimo numero di Resistere all’inevitabile del 2024! ✨ O anche di quello che io chiamo l’anno più significativo della mia vita fino a ora, per diversi motivi. Sono felice di avere, tra le altre cose, creato questo spazio e condiviso con voi i miei pensieri e approfondimenti. Confido di continuare il prossimo anno a scrivere - con la rigorosa non-costanza che lo contraddistingue - di storie di tecnologia e società, augurandomi possano arrivarne di più positive rispetto a quelle degli ultimi mesi. Alcune disposizioni significative del Regolamento europeo sull’Intelligenza Artificiale, ad esempio, saranno applicate nel 2025 e questo ci permetterà di iniziare a comprendere il suo impatto.

Andiamo!

Tendo a provare un senso di sconforto quando vicende drammatiche del presente (o addirittura del passato) che coinvolgono l’utilizzo di tecnologie digitali e processi automatizzati vengono paragonate ai grandi film di fantascienza (e succede molto spesso, ad esempio con Minority Report). Questo perché temo che, così facendo, si rischi di far passare un messaggio sbagliato: e cioè che quell’episodio drammatico non sia altro che un tentativo isolato di “anticipare” il futuro, un caso particolarmente innovativo, fantascientifico, lontano e distante. In realtà, moltissimi di questi casi raccontano ormai di pratiche consolidate e diffuse da anni, che già causano impatti significativi (e molto poco digitali) e che sarebbe forse più utile analizzare con lenti estremamente realistiche e concrete, per poterle veramente prendere sul serio.

Nell’ultimo mese ho studiato una storia che conoscevo in realtà già molto bene. A fine novembre, un articolo di Lighthouse Reports ha svelato il lavoro che l'Agenzia per le assicurazioni sociali svedese (Försäkringskassan) ha condotto silenziosamente negli ultimi anni attraverso l’uso di alcuni algoritmi che calcolano un livello di rischio e assegnano un punteggio a centinaia di migliaia di persone che percepiscono sussidi, con lo scopo di prevedere se commetteranno delle frodi. L'analisi del set di dati ha rivelato che il progetto di previsione delle frodi dell'agenzia discriminava le donne, gli immigrati, i lavoratori a basso reddito e le persone senza istruzione universitaria.

Vi ricorda qualcosa? La luce gettata sull’utilizzo di un sistema di classificazione basato su un presunto rischio associato ad alcuni gruppi sociali rimanda allo scandalo sui sussidi esploso nel 2021 nei Paesi Bassi, che ho raccontato con molti particolari in Tdr e in vari episodi di questa newsletter (ma anche ovunque mi abbiate incrociata online o sentita parlare negli ultimi tre anni 😅), e a un altro caso sostanzialmente identico in capo al governo francese e alla sua agenzia per la sicurezza sociale.

La Svezia, così come i Paesi Bassi, vengono regolarmente acclamati come modelli per lo Stato sociale. Sono entrambi in cima agli indici europei (come il DESI Index) e globali di trasparenza e ottengono alti livelli di fiducia da parte dei cittadini. Sono anche alcuni dei paesi europei che più investono nell’utilizzo di tecnologie emergenti nei servizi pubblici, e credo sia molto significativo che questi episodi continuino ad accadere laddove questi esperimenti vengono effettivamente portati avanti.

La domanda che chi monitora questi casi si pone regolarmente è: in quanti altri paesi sta avvenendo qualcosa di simile, senza che sia possibile saperlo?

Come già accaduto per il caso olandese e quello francese, Lighthouse Reports ha dovuto lavorare per anni, mandare dozzine di richieste di accesso all’amministrazione e anche portarla due voltre in tribunale per ottenere finalmente accesso alle informazioni rilevanti sul progetto e sui dati su cui il modello era addestrato. Come raccontano i giornalisti, alcune fonti dell'Agenzia per i sussidi e i servizi sociali - hanno descritto questi algoritmi come il loro “segreto meglio custodito”. I beneficiari di sussidi e aiuti che sono stati segnalati, accusati o esclusi dal servizio in nome di un rischio di frode potenziale frode non hanno idea di essere stati identificati da un algoritmo.

L’analisi dei dati che hanno portato avanti insieme ad alcune esperte ed esperti ha rivelato le caratteristiche di migliaia di richiedenti al programma svedese che supporta i genitori che si prendono cura dei figli malati (praticamente lo stesso sussidio specifico al centro del Toeslagenaffaire olandese). Ognuno di loro era stato segnalato come sospetto da un algoritmo predittivo che aveva il compito di anticipare un rischio di frode (che quindi non era ancora avvenuta) sulla base di statistiche e dati storici che raccontavano dei casi positivi di frode negli anni precedenti. Alcuni gruppi sociali, che corrispondevano a delle “categorie” etichettate all’interno del modello, erano considerate più a rischio a parità di condizioni e avevano maggiori probabilità di essere erroneamente etichettate come sospette dal sistema. Attraverso alcuni test di statistical parity, Lighthouse ha concluso che a essere strutturalmente discriminate e “sovraselezionate” erano le donne, le persone con background migratorio, i lavoratori a basso reddito e le persone senza istruzione universitaria.

Quando, negli ultimi tre anni, ho portato avanti la mia ricerca empirica sul caso olandese, ero particolarmente interessata a capire se - e come - la cultura specifica di un paese può influenzare le discriminazioni automatizzate e istituzionalizzate. Alcune categorie di rischio, infatti, cambiano da paese a paese e sembrano essere specifiche della storia di una nazione e del suo rapporto con l’oppressione di alcuni gruppi sociali (nel caso dei Paesi Bassi, la storia coloniale è molto influente in questo senso).

È evidente però che oltre a un’osservazione più specifica del contesto, il problema che accomuna questi progetti abbia a che fare con forme di discriminazioni strutturali ed estese almeno a tutto il mondo occidentale (razzismo, misoginia, classismo), che io ad esempio ho interpretato come un altro livello della cultura e dell’interazione tra esseri umani, società e tecnologia, e che prescinde da valori culturali più situati per appoggiarsi invece all’automazione per deresponsabilizzare importanti scelte politiche.

Non è ovviamente un caso che in tutti e tre i casi citati sopra una delle categorie con cui le persone venivano analizzate sia il genere, e che ad essere considerate come “ad alto rischio” siano sempre più le donne rispetto agli uomini. In questo senso, la violenza economica e sociale di genere si perpetra anche attraverso l’automazione di controlli polizieschi sui servizi sociali - gli stessi servizi che invece dovrebbero supportare proprio queste stesse categorie sociali.

Nel caso della Svezia e dei Paesi Bassi, i sussidi su cui venivano eseguiti controlli erano quelli che riguardavano la crescita dei figli e l’assistenza all’infanzia. Amplificando l’immagine della madre che cresce e si prende cura dei figli, che sono sua e unica diretta responsabilità, è la donna madre a essere considerata a rischio di frodare lo Stato nella richiesta di aiuti.

Viviamo in un contesto europeo dove attualmente alcuni gruppi sociali, come ad esempio le donne, e ancora di più se madri, vengono considerati colpevoli fino a prova contraria. In questo scenario, i sistemi di classificazione basati su apprendimento automatico svolgono un ruolo importante, ma a essere veramente preoccupante è come ormai decine di governi e agenzie pubbliche - nonostante gli scandali e i numerosi errori documentati in questi anni - continuino a mettere in atto le stesse pratiche, proprio in quei servizi - come quelli legati allo Stato sociale - che dovrebbero supportare queste persone.

Ciò che è appena successo in Svezia non ha nulla a che vedere con la fantascienza, ma con pratiche sempre più diffuse e radicate nei processi amministrativi classici. Il che rivela, evidentemente, come oltre il piano culturale più specifico ci sia una cultura più ampia rispetto a come ci affidiamo a queste tecnologie per giustificare decisioni e comportamenti profondamente disumani. Visualizzarlo nella sua piena concretezza potrebbe aiutarci a svelarli.

🌍 (Altre) notizie dal mondo

🇮🇹 Italia

Il Garante per la privacy ha appena concluso la sua istruttoria nei confronti di OpenAI, che era stata avviata a marzo 2023 e aveva provocato gran clamore (“l’Italia blocca l’innovazione”) con una multa di 15 milioni. Le violazioni riscontrate sono tre:

l’azienda ha trattato i dati degli utenti senza prima «individuare un’adeguata base giuridica»;

non ha informato correttamente gli utenti sulla raccolta e sul trattamento dei loro dati personali;

non ha istituito i dovuti meccanismi di verifica dell’età, per limitare l’esposizione a contenuti inopportuni ai minori di 13 anni.

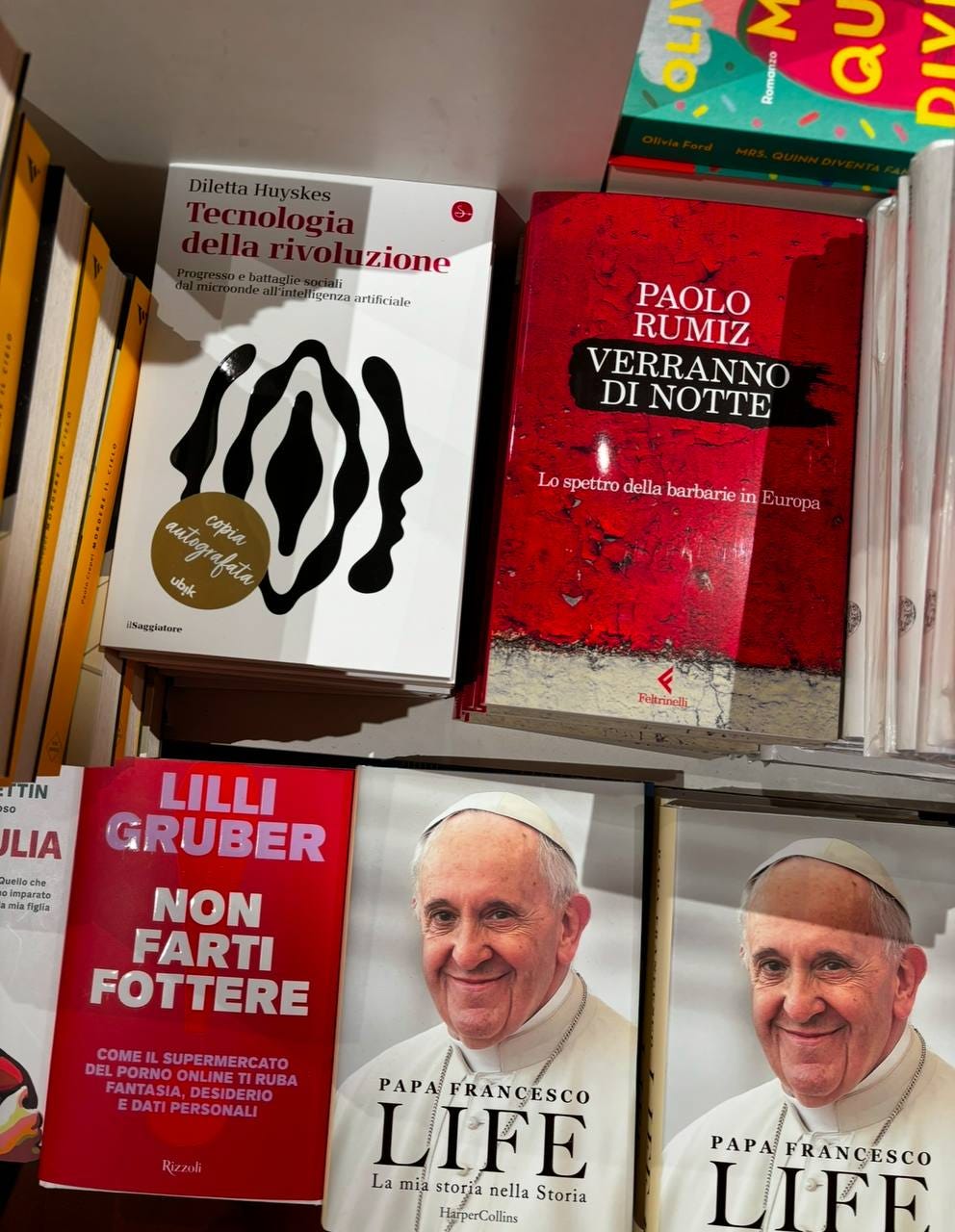

Se queste storie ti incuriosiscono, e soprattutto ti interessa ragionare sui metodi alternativi con cui ripensare e progettare questi strumenti e il nostro rapporto sociale, culturale e politico con le tecnologie (o pensi che qualcunə che conosci possa volerlo!) trovi queste riflessioni in Tecnologia della rivoluzione, che oggi compie 6 mesi. Se vuoi portare la critica all’inevitabilismo tecnologico o spiegare alla zia durante il Cenone perché non è vero che con l’intelligenza artificiale siamo finitə, potresti regalarlo per Natale :)

Vi auguro dei giorni di riposo, affetto, cura e un po’ di leggerezza. Spero possano essere per tuttə giorni meno difficili possibile 🤍

📬 Se siete arrivatɜ fino a qui, grazie di cuore! Per questo numero è tutto. Mi piacerebbe molto sapere cosa ne pensate, o se avete domande da condividere e/o suggerimenti. Potete sempre scrivermi a info@dilettahuyskes.eu. Se vi va di aiutarmi a creare questa piccola comunità di curiosɜ, potete condividere questa newsletter con altre persone che pensate possano essere interessate.

Ci sentiamo il prossimo mese (forse)!

Diletta