#9 Uccisa da un uomo (non da un algoritmo)

Un racconto forte che tutt3 dovremmo conoscere: in Spagna, come ovunque, il sistema di valutazione del rischio di violenza di genere fallisce. E la sua automazione non può essere una soluzione.

Ciao, e benvenutə a un nuovo numero - per nulla puntuale - di Resistere all’inevitabile! ✨ una novità: ringrazio Matilda Ferraris, con cui collaboro da tempo, per averlo costruito insieme a me.

Immagina di essere una donna che ha deciso di varcare la soglia di un commissariato. È una scelta difficile, una lotta contro sentimenti estremamente discordanti. Ma sei lì. Sei tra le poche che ce l’hanno fatta, perché sappiamo che la maggior parte di noi non denuncia.

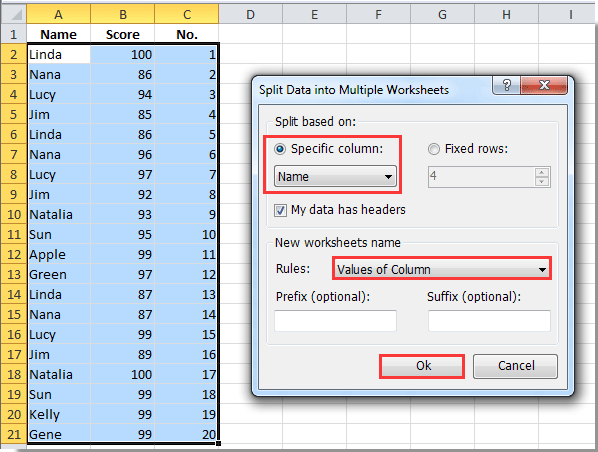

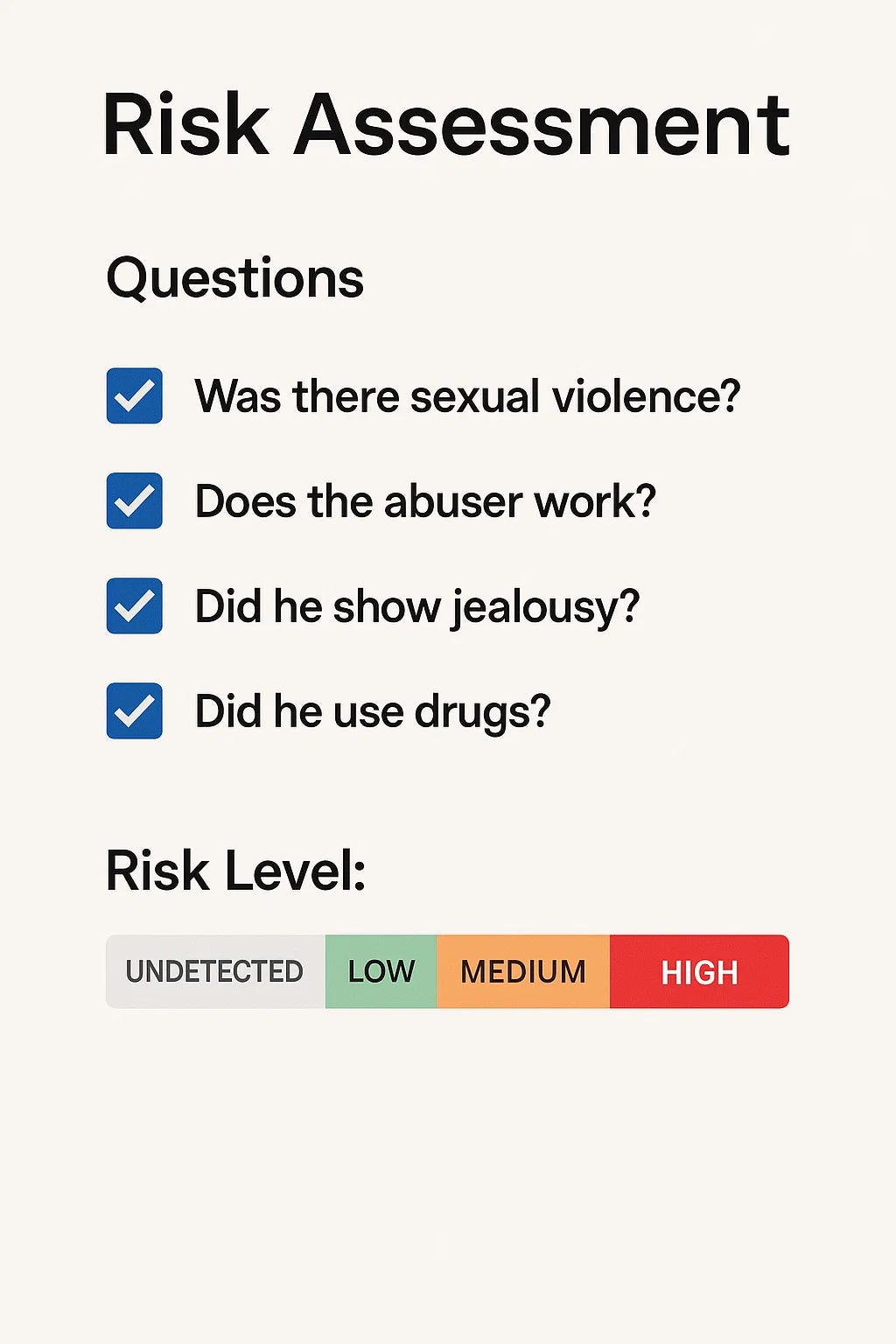

Ora sei seduta davanti a un agente. Lui non ti guarda davvero negli occhi, sta leggendo lo schermo e inizia a digitare le tue generalità sulla tastiera. Inizia a farti delle domande. Domande secche, precise: “C'è stata violenza sessuale?” “L’aggressore lavora?” “Ha mostrato gelosia?” “Ha fatto uso di droghe?”. Per ogni voce, tu devi rispondere “presente” o “non presente”.

Non stai solo fornendo dettagli generici su ciò che è accaduto. Stai compilando, senza saperlo, un modello. Un algoritmo sta prendendo forma tra le righe della tua storia, e quelle risposte finiranno in un sistema che assegnerà al tuo caso un punteggio: rischio non rilevato, basso, medio, alto, estremo. Sarà quel numero, più che le tue parole, a determinare quale protezione riceverai. Se qualcuno verrà a controllare ogni tanto. Se avrai un pulsante d’allarme da premere. Se sarai creduta.

A gennaio, Lina aveva trovato il coraggio di denunciare. Viveva a Benalmádena, una cittadina affacciata sul mare nel sud della Spagna, dove l’ex compagno aveva dimostrato un atteggiamento violento. Secondo suo cugino Daniel, non era la prima volta: la violenza c’era già stata. Lina aveva deciso di recarsi alla stazione di polizia e raccontare l’accaduto. In quel momento, il suo caso era stato inserito nel sistema VioGén.

Il risultato: rischio medio. Aveva chiesto un ordine restrittivo, si era rivolta a uno specialista presso la corte di Málaga, chiedendo di non dover condividere ancora gli stessi spazi con quell’uomo. La richiesta era stata respinta. Tre settimane dopo, Lina è morta. Uccisa da quello stesso uomo che aveva già denunciato.

Lui aveva usato le vecchie chiavi per entrare in casa, mentre Lina era dentro con i bambini, ha appiccato il fuoco, e mentre lui, i figli, e la madre di Lina sono riusciti a fuggire, lei no. Il suo corpo è stato ritrovato tra le ceneri.

Il protocollo VioGén prevede che, in caso di rischio medio, la polizia effettui un controllo entro trenta giorni dalla denuncia. Quando il rischio viene considerato “alto”, il controllo avviene entro una settimana. Ma Lina a quei trenta giorni dopo la denuncia non ci è mai arrivata.

La prima volta che ho scritto di VioGèn era il 2022, insieme all’amica e collega Silvia Semenzin. Ne avevamo raccontato il funzionamento per Wired spiegando come il software utilizzi i dati delle denunce per fare previsioni di rischio, analizzando le risposte delle persone che segnalano episodi di violenza alla polizia e assegnando un livello di protezione corrispondente in base alla gravità riscontrata. Ma soprattutto, avevamo riflettuto sui tassi di errore e sulle implicazioni più ampie dell’affidare decisioni così sensibili a un software.

In questo caso - come in molti altri - parliamo di affidamento con cognizione di causa (purtroppo). La Spagna, tra gli altri paesi che nel contesto europeo si affida a sistemi simili, è l’unico in cui un algoritmo è integrato in modo così profondo nella prassi operativa della polizia. E come hanno scritto Adam Satariano e Roser Toll Pifarre sul New York Times in un lungo approfondimento dedicato a VioGén, è molto difficile capire quando finiscono le raccomandazioni del software e quando cominciano le decisioni prese dagli esseri umani.

A novembre, in Spagna erano oltre 100.000 i casi attivi di donne valutate tramite VioGén, con circa l’85% delle vittime classificate come esposte a un basso rischio di subire nuovamente violenza da parte del proprio aggressore. Gli agenti di polizia in Spagna sono formati per poter ignorare le raccomandazioni di VioGén se le prove lo giustificano, ma il New York Times ha rilevato che i punteggi di rischio vengono accettati nel 95% dei casi.

Quella percentuale, 95%, fa pensare che il bias dell’automazione sia molto forte nel caso di VioGén, e cioè che le forze di polizia diano per buono il punteggio di rischio offerto dal sistema senza verificarlo o legittimarlo con un controllo umano. Di questo tema, esponendo anche dati empirici sulle pubbliche amministrazioni italiane e il loro rapporto con l’automazione, ho scritto a fondo in un altro episodio di questa newsletter dedicato all’algoritmo della scuola italiana.

È un fattore che ritorna, nel nostro rapporto con le tecnologie, e lo dimostra il fatto che nelle ultime settimane, dopo la notizia della morte di Lina, ho letto moltissimi commenti, soprattutto su LinkedIn, da parte di persone che si occupano di intelligenza artificiale e discriminazione. Molti di loro hanno ripreso il caso scrivendo frasi clickbait come “una donna è stata uccisa da un algoritmo” o “l’intelligenza artificiale l’ha uccisa”. È stato proprio questo modo di raccontare la vicenda che mi ha spinta a scrivere questa newsletter.

Perché credo sia importante conoscere e raccontare questi episodi senza sensazionalismi, oggi più che mai. Si parla di algoritmi, si cerca la colpa in una tecnologia imperfetta, ma si perde il punto centrale: Lina è stata uccisa da un uomo, dal suo ex compagno. I veri complici, prima ancora dell’intelligenza artificiale, sono un sistema patriarcale, di potere e di incompetenza, che ha deciso – per convenienza, per incapacità, per abitudine – di gestire in questo modo l’interazione tra raccomandazioni automatiche e decisioni umane.

Come in tanti altri casi, non è l’algoritmo ad aver fallito, ma le istituzioni. È l’insieme di attori che ha rifiutato audit indipendenti, che non ha formato in modo adeguato chi lavora a stretto contatto con le vittime, che ha lasciato che una valutazione di “rischio medio” bastasse a fermarsi lì. In questo senso, la responsabilità è tutta umana: nell’architettura dei sistemi, nel modo in cui vengono usati, nella superficialità con cui si accettano come verità. Anche quando i dati inseriti sono accurati, questi strumenti predittivi rischiano di legittimare pratiche sbagliate da parte della polizia, dietro la copertura della “scienza dei dati”. È già successo molte volte.

Se davvero vogliamo che la tecnologia possa aiutare nel contrasto alla violenza di genere, allora bisogna cominciare da tutt’altra parte: competenze ed educazione. Formare gli agenti non solo nella gestione dei dati, ma prima ancora nella capacità di interlocuzione, di ascolto, di cura. Valutare le prestazioni, rendere le decisioni più responsabili e trasparenti. Solo allora la tecnologia potrà essere un supporto utile, non una scorciatoia rischiosa. Studi scientifici dimostrano che, nei contesti automatizzati, la responsabilizzazione degli esseri umani riduce gli errori1. Quando chi prende decisioni sa che verrà valutato, che ha un ruolo attivo e che ne risponde, il cosiddetto automation bias diminuisce. Il problema non è la presenza dell’algoritmo. È la mancanza di vigilanza, l’assenza di sensibilità. In un contesto così sociale e sensibile come quello della violenza di genere, le responsabilità – e gli errori – non possono che essere umane.

Solo perché possiamo, non significa che dovremmo.

Perché la domanda fondamentale – quella che noi chiamiamo “domanda zero” nel lavoro che facciamo con Immanence – è: serve davvero un sistema di intelligenza artificiale in questo processo? In questo contesto? È davvero auspicabile? E se sì, perché? Non lo chiediamo per escludere l’uso della tecnologia, ma per riportare il focus su ciò che conta davvero: comprendere a fondo il problema che si vuole affrontare, e costruire strumenti che siano all’altezza della complessità che pretendono di gestire.

🌍 Notizie dal mondo

🇮🇹 La settimana scorsa abbiamo pubblicato il primo report dell’Osservatorio Amministrazione Automatizzata di Privacy Network! È il risultato molto atteso di un lavoro decisamente complesso, a volte molto frustrante, ma anche entusiasmante cominciato nel 2021 con il lancio dell’Osservatorio. Dentro il report troverete il racconto di queste difficoltà, un’analisi dell’utilizzo di strumenti automatizzati e di IA da parte delle amministrazioni pubbliche centrali in Italia, e una mappatura concreta di questi divisi in quattro verticali: (i) sicurezza e polizia predittiva, (ii) richieste di asilo e accoglienza, (iii) verifiche fiscali e (iv) istruzione. Grazie a tutte le persone che l’hanno reso possibile, e ora continuiamo!

🇰🇪 “Il mondo è un posto malvagio e nessuno verrà a salvarti”. È così che James Oyange (Mojez), ex moderatore di contenuti a Nairobi, ha descritto il giorno in cui è finito inconsapevolmente in uno dei lavori più traumatici della filiera globale dell'intelligenza artificiale. Un’inchiesta ha portato alla luce il costo umano nascosto dell'intelligenza artificiale, attraverso le esperienze vissute dai lavoratori digitali sottopagati e invisibili di Nairobi:

“Questi lavoratori sono tenuti nascosti per un motivo. Si dice che se i macelli avessero pareti di vetro, il mondo smetterebbe di mangiare carne. Se le aziende tecnologiche rivelassero cosa fanno fare a questi lavoratori digitali, forse il mondo smetterebbe di usare le loro piattaforme”.

Questi sono i temi che affronta la seminar series che organizzo da qualche mese nell’ambito del lavoro di ricerca al Philtech dell’Università degli Studi di Milano, Towards a Decolonization of Artificial Intelligence. Ci si può registrare ai prossimi due - e ultimi - appuntamenti su Eventbrite.

🇺🇸 Negli Stati Uniti, un importante studio legale con sede in California è stato multato per aver presentato un documento giudiziario scritto con l’ausilio di modelli linguistici generativi, tra cui Gemini. Il giudice, insospettito dalle fonti citate, ha scoperto che molti riferimenti legali erano inventati. In seguito, lo studio ha presentato una seconda memoria, con ancora più errori. Il risultato: una multa da 31.000 dollari e l’obbligo per gli avvocati coinvolti di giurare sotto testimonianza come siano arrivati a fidarsi ciecamente dell’output dell’IA.

📂 Archivio tecnofemminista

✨ Il 5 maggio ho discusso (e difeso!) la mia tesi di dottorato e conseguito il titolo, è stata una grande emozione e una bellissima giornata. Forse, per una volta, sono riuscita davvero a godermela.

Il lavoro di ricerca a cui ho lavorato dal 2021 tra Italia e Paesi Bassi, Constructing Automated Societies. Socio-cultural Determinants and Impacts of Automated Decision Making in Public Services è ora disponibile online a questo link.

✨ Un’altra pubblicazione accademica alla quale ho contribuito è ora disponibile! Il libro Governing the Digital Society, edito dalla Amsterdam University Press, è pubblicato in open access. Presenta una serie di approcci alla governance, concentrandosi sulle piattaforme online, sull'intelligenza artificiale e sui valori pubblici che sono alla base di queste tecnologie. Sono molto felice di aver scritto insieme a Gerwin van Schie e Laura Candidatu il capitolo “Motherhood in the Datafied Welfare State: Investigating the Gendered and Racialized Enactment of Citizenship in Dutch Algorithmic Governance” e sono grata ai curatori José van Dijk, Karin van Es, Anne Helmond e Fernando van der Vlist.

🗓 Dove ci vediamo?

Giovedì 29 maggio sarò a Cagliari per la tappa sarda dell’Open Summit di Startup Italia dove aprirò la giornata con una presentazione del mio libro Tecnologia della rivoluzione.

L’11 giugno sarò ospite di United Ventures e Bologna Business School per l’evento AI, Impresa e Venture Capital insieme a Daniele Panfilo, Simone Di Somma e Massimiliano Magrini.

Dall’11 al 13 giugno sarò alla conferenza STS Italia – The Italian Society for Social Studies of Science and Technology. Se qualcun altrə sarà lì, incontriamoci!

📬 Se siete arrivatɜ fino a qui, grazie di cuore! Per questo numero è tutto. Mi piacerebbe molto sapere cosa ne pensate, o se avete domande da condividere e/o suggerimenti. Potete sempre scrivermi a info@dilettahuyskes.eu. Se vi va di aiutarmi a creare questa piccola comunità di curiosɜ, potete condividere questa newsletter con altre persone che pensate possano essere interessate.

Ci sentiamo il prossimo mese (forse)!

Diletta

Skitka, L. J., Mosier, K. L., & Burdick, M. (2000). Accountability and automation bias. International Journal of Human-Computer Studies, 52, 701 - 717.

Oltre alla questione dell’uso del sistema Viogén da parte della polizia spagnola, è interessante raccogliere anche i casi in cui emergono conflitti di interesse diretti, come nel caso eclatante di Granada: https://substack.com/@barcellonachiamaitalia/p-161592132.

Questo episodio dimostra che, oltre ai limiti tecnologici del sistema, esiste anche una grave carenza di formazione degli agenti di polizia in materia di violenza di genere.